Le Technology Innovation Institute (TII), un centre de recherche scientifique pionnier à l’échelle mondiale et le pilier de la recherche appliquée du Conseil de recherche en technologies avancées d’Abou Dhabi (ATRC), a publié un nouveau grand modèle de langage dans sa série Falcon, le Falcon Mamba 7B. Ce nouveau modèle est le modèle de langage en espace d’état (SSLM) open source le plus performant au monde, comme l’a vérifié indépendamment Hugging Face.

Premier SSLM pour Falcon, ce modèle diffère des modèles Falcon précédents qui utilisaient tous une architecture basée sur le transformateur. Ce nouveau modèle Falcon Mamba 7B constitue un nouvel exemple des efforts pionniers en matière de la recherche menés par l’institut et des outils et produits révolutionnaires qu’il met à la disposition de la communauté sous forme open source.

Son Excellence Faisal Al Bannai, Secrétaire général de l’ATRC et conseiller du Président des Émirats Arabes Unis pour la recherche stratégique et les technologies avancées, a déclaré : « Falcon Mamba 7B marque le quatrième modèle d’IA consécutif le mieux classé par le TII, renforçant ainsi la position d’Abou Dhabi en tant que pôle mondial de la recherche et du développement en IA. Cet exploit souligne l’engagement indéfectible des Émirats Arabes Unis en faveur de l’innovation ».

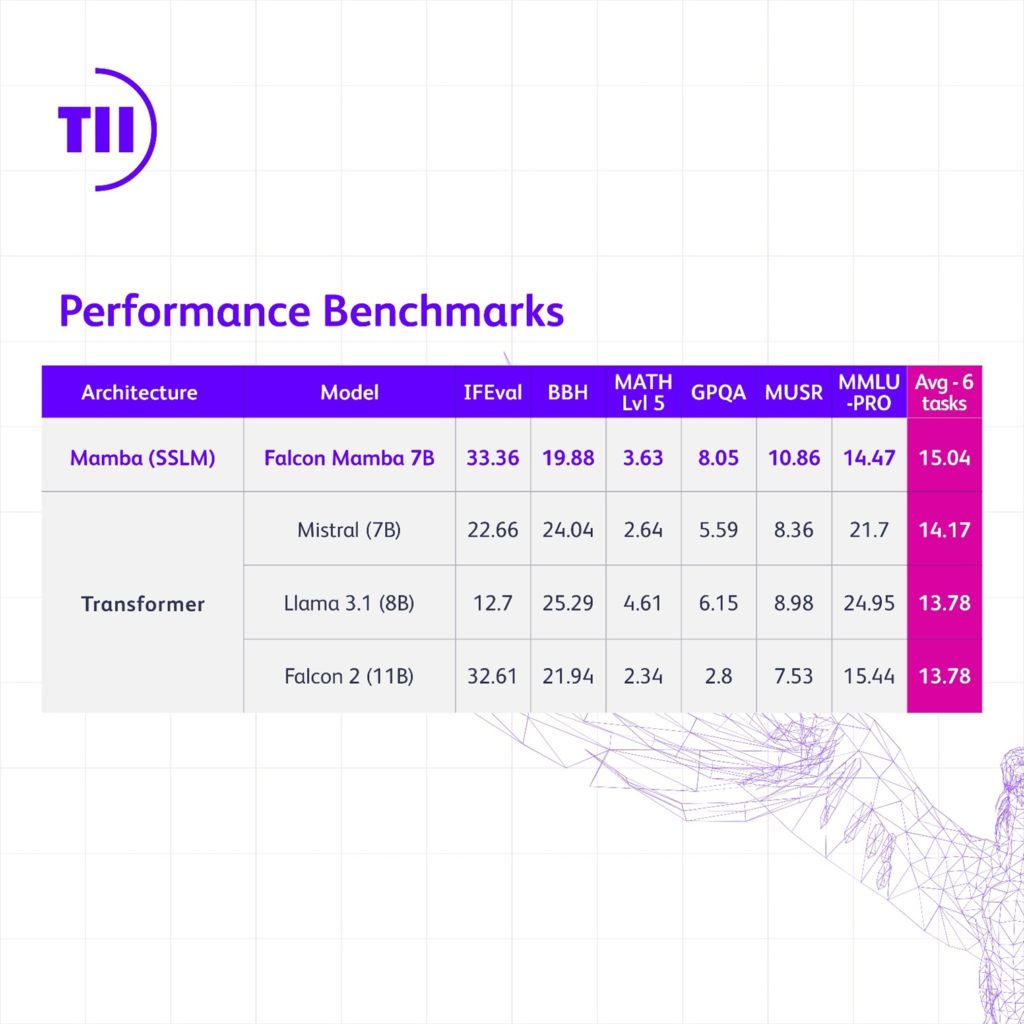

Pour les modèles d’architecture de transformateur, Falcon Mamba 7B surpasse Llama 3.1 8B, Llama 3 8B de Meta et Mistral 7B selon les nouveaux benchmarks introduits par Hugging Face. Par ailleurs, pour les autres SSLM, Falcon Mamba 7B dépasse tous les autres modèles open source sur les anciens benchmarks et sera le premier modèle à figurer sur le nouveau classement de référence plus rigoureux de Hugging Face.

Dr Najwa Aaraj, Directrice générale de TII, a déclaré : « Le Technology Innovation Institute continue de repousser les limites de la technologie avec sa série Falcon de modèles d’IA. Le Falcon Mamba 7B représente un véritable travail pionnier et ouvre la voie à de futures innovations en IA qui amélioreront les capacités humaines et la qualité de vie ».

Les modèles d’espace d’état sont extrêmement performants pour comprendre des situations complexes qui évoluent dans le temps, comme un livre entier. Cela est dû au fait que les SSLM n’ont pas besoin de mémoire supplémentaire pour digérer de si grandes quantités d’informations.

D’autre part, les modèles basés sur les transformateurs sont très efficaces pour mémoriser et utiliser les informations traitées précédemment dans une séquence. Cela en fait un outil inestimable pour des tâches comme la génération de contenu. Cependant, et comme ils comparent chaque mot avec tous les autres, cela requiert une puissance de calcul considérable.

Les SSLM peuvent trouver des applications dans divers domaines tels que l’estimation, la prévision et le contrôle. Similairement aux modèles d’architecture de transformateur, ils excellent également dans les tâches de traitement du langage naturel (PNI) et peuvent être appliqués à la traduction automatique, aux résumés de texte, à la vision par ordinateur et au traitement audio.

Dr Hakim Hacid, chercheur en chef par intérim de l’unité inter-centres sur l’IA du TII, a déclaré : « Alors que nous lançons le Falcon Mamba 7B, je suis fier de l’écosystème collaboratif du TII qui a permis d’entretenir son développement. Le lancement de ce nouveau modèle représente une avancée significative, inspirant de nouvelles perspectives et alimentant davantage la quête de systèmes intelligents. Au TII, nous repoussons les limites des modèles SSLM et des modèles de transformateur pour stimuler l’innovation dans l’IA générative ».

Les grands modèles de langage Falcon ont été téléchargés plus de 45 millions de fois, ce qui prouve le succès exceptionnel de ces modèles. Falcon Mamba 7B sera publié sous la licence TII Falcon 2.0, la licence logicielle permissive construite sur les principes du logiciel Apache 2.0 qui comprend une politique d’utilisation acceptable qui préconise l’utilisation responsable de l’IA. Plus d’informations sur le nouveau modèle sont disponibles sur FalconLLM.TII.ae.

Le texte du communiqué issu d’une traduction ne doit d’aucune manière être considéré comme officiel. La seule version du communiqué qui fasse foi est celle du communiqué dans sa langue d’origine. La traduction devra toujours être confrontée au texte source, qui fera jurisprudence.