Dans un texte de 1990 intitulé « Vers une ère post-média », Félix Guattari s’interrogeait sur les évolutions des technologies médiatiques. La jonction entre la télévision, la télématique et l’informatique devaient selon lui conduire à un renversement des pratiques, permettant aux récepteurs passifs de se réapproprier les « machines d’information, de communication, d’intelligence, d’art et de culture » et de remanier le « pouvoir mass-médiatique » écrasant les subjectivités.

De l’ère post-média à l’ère post-vérité

Trente ans plus tard, les « pratiques moléculaires alternatives » alors envisagées par Guattari ne semblent pas avoir suffi. À « l’ère post-média » s’est en effet substituée « l’ère post-vérité » qui correspond aussi à celle de la « post-démocratie ». À en croire ces deux expressions, l’époque de l’intelligence artificielle et des technologies numériques serait aussi celle de la fin de la vérité et de la démocratie, deux pratiques apparues dans un milieu technique tout à fait différent et spécifique : celui de l’écriture phonétique.

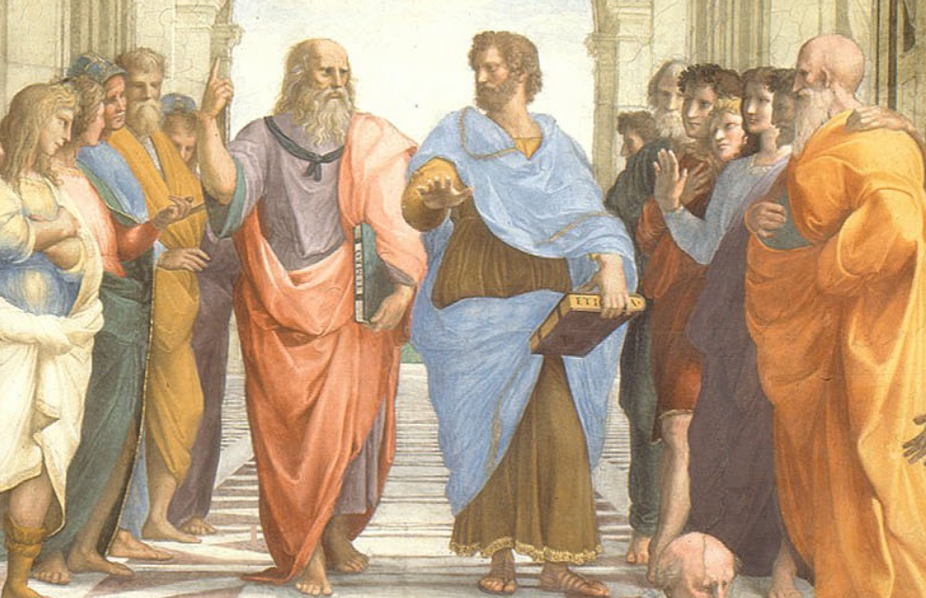

Comme l’ont montré les travaux de Jean‑Pierre Vernant ou de Marcel Détienne sur la cité grecque, la technique de l’écriture permet la publication de la loi, ainsi que sa mise en débat par des citoyens ayant appris à lire et à écrire : à mesure que les lois sont placées sous le regard de tous et discutées dans l’Agora, le pouvoir royal ou aristocratique se voit remplacé par un ordre légal démocratique. La vérité ne prend plus la forme de la « révélation » ou du « mystère » réservés à un « cercle restreint d’initiés », mais celle d’une vérité ouverte et accessible « qui fonde sur sa propre force démonstrative ses critères de validité ». Bref, « les règles du jeu politique – la libre discussion, le débat contradictoire, l’affrontement des argumentations contraires – s’imposent comme règles du jeu intellectuel » dans un espace public à la fois rationnel et politique, qui se reconfigure autour de l’écriture phonétique.

Qu’en est-il de l’espace public à l’époque des entreprises numériques planétaires ? Qu’en est-il de la vérité démonstrative et argumentée à l’époque de la « fin de la théorie », alors que les calculs sur des quantités massives de données tendent à remplacer l’exercice de la pensée ? Qu’en est-il de la vie démocratique et de la société politique, à l’époque de la « gouvernementalité algorithmique », au sein de laquelle le pouvoir statistique tend à remplacer la normativité juridique ?

L’économie de l’attention : de la collecte des données à la « désinformation »

Les technologies numériques contemporaines soulèvent en effet de nombreux enjeux, à la fois scientifiques et politiques : outre « l’infodémie », désormais reconnue comme un problème de santé publique, la collecte des données et le profilage algorithmique sont apparus comme des menaces pour les droits humains, suite aux scandales provoqués par le ciblage des citoyens.

Depuis leur développement des années 2000 à 2010, les réseaux dits « sociaux » sont devenus à la fois des lieux de traçage des activités et de circulation d’informations non certifiées, qui contribuent souvent à la dissémination de la haine, à la polarisation des opinions ou à la stigmatisation de certaines populations. De plus, l’économie de l’attention qui commande le fonctionnement de la plupart des plates-formes implique de maximiser l’engagement des utilisateurs, quitte à leur recommander automatiquement les contenus les plus sensationnels, les plus abêtissants ou même les plus violents, qui sont souvent les plus « likés », donc les plus diffusés, au détriment d’autres contenus potentiellement plus intéressants, mais aussi plus exigeants, qui sont de fait invisibilisés.

« Infodémie » et discrédit

Comme le soulignent Yves Poullet et Noemi Bontridder, si la distorsion de la réalité et les appels à la violence ne sont pas nouveaux, les réseaux numériques semblent néanmoins engendrer des risques spécifiques : outre la vitesse et l’ampleur de la diffusion des informations, la possibilité de cibler automatiquement les publics rend d’autant plus efficace la manipulation des comportements. De plus, la génération automatique de contenus par des logiciels ou des algorithmes masque la source des informations reçues et contribue à une liquidation progressive de la confiance et du crédit accordé aux contenus – confiance et crédit qui constituent pourtant les conditions de possibilité de toute société.

En effet, comme le rappelait Bernard Stiegler, toute société suppose « un crédit que s’accorde le groupe social », un « gage de confiance mutuelle primordiale sans lequel aucun échange ne peut s’instaurer durablement, ni entre les membres de la société, ni entre les générations ». Si la plupart des échanges (qu’ils soient marchands, professionnels, symboliques, culturels, sociaux, familiaux, amoureux, etc.) sont désormais médiatisés par les environnements numériques, on comprend l’importance de restaurer la confiance et le crédit en ces technologies.

Vers un espace public numérique et herméneutique ?

Face à ces enjeux, les solutions tournent souvent autour de deux propositions : la régulation des contenus d’une part, qui devrait permettre de repérer les informations trompeuses, et la protection des données ou le paramétrage des recommandations d’autre part, qui devrait permettre aux utilisateurs de protéger leur vie privée et de modifier les paramètres utilisés pour les « cibler ». De telles mesures, bien que nécessaires, risquent néanmoins de se révéler peu efficaces, en raison du nombre de contenus diffusés et de la vitesse de leur propagation, qui fait obstacle à leur modération, et en raison des dispositifs « captologiques », qui sollicitent les pulsions infra-conscientes pour influencer les conduites, avant même que les individus n’aient pu paramétrer les systèmes pour protéger leurs données.

Au-delà des contenus et des données, ce sont donc les modèles d’affaires et les fonctionnements techniques des plates-formes qui constituent les principaux dangers : c’est l’écosystème numérique lui-même qui semble devoir être transformé. Face aux réseaux fondés sur l’individualisation des profils, la quantification de soi et les comportements mimétiques, la constitution de réseaux véritablement sociaux pourrait permettre l’individuation collective de groupes diversifiés et l’expression des singularités, nécessaire à la controverse scientifique comme au débat démocratique.

D’un modèle hégémonique basé sur la génération automatique d’informations par les algorithmes, sur la recommandation ciblée de contenus sensationnels et sur l’exploitation des ressources attentionnelles, il s’agirait de passer à des dispositifs herméneutiques et délibératifs, permettant aux sujets d’exprimer leurs interprétations et leurs points de vue singuliers, de se recommander les uns aux autres des contenus certifiés, et de discuter collectivement à travers des controverses ou des débats argumentés, au cours desquels seulement lesdites « vérités » peuvent émerger, et avec elles, le crédit et la confiance qui leur sont accordés.

Comme le rappelle Giuseppe Longo, même les vérités scientifiques supposent la « composante critique de la démocratie », qui permet de s’écarter de la majorité, des moyennes et de la banalité, pour explorer des voix nouvelles de pensée et introduire de la signification dans les quantités massives d’informations. Si l’ère post-média n’est plus d’actualité dans des environnements intégralement connectés, il semble plus que jamais nécessaire d’expérimenter de nouvelles pratiques et de nouveaux dispositifs pour réinventer la démocratie dans le milieu numérique.

Anne Alombert

Enseignante-chercheuse en philosophie à l’Université Catholique de Lille, Université Paris Nanterre – Université Paris Lumières